Verifica le date inserite: la data di inizio deve precedere quella di fine

Alessandro Y. Longo

Leggi i suoi articoliInizio da un'immagine

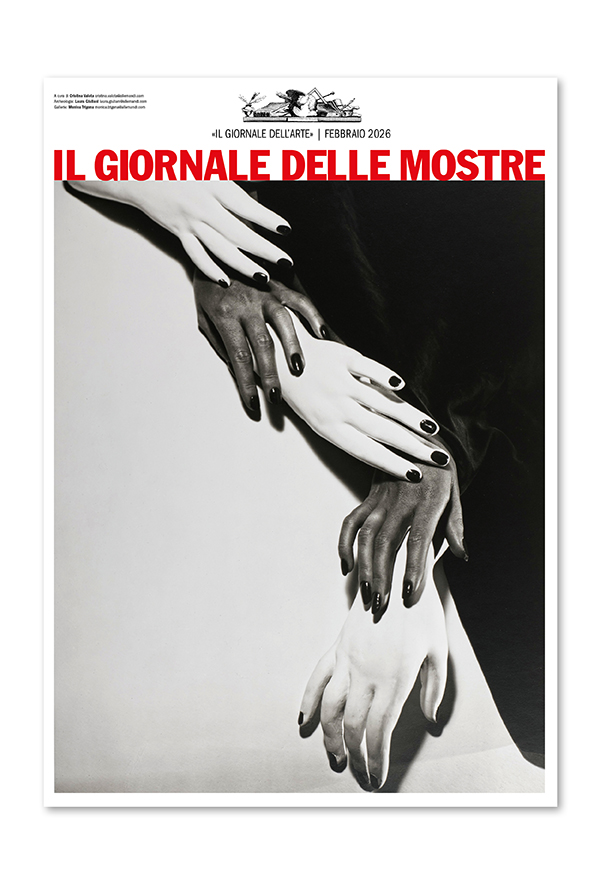

Inizierò da un’immagine. È una foto in bianco e nero, con ombre tendenti all’ambra; due donne stanno nell’inquadratura e la prima sembra guardare qualcosa alla sinistra; dietro di lei, l’altra si appoggia alla sua schiena, quasi per nascondersi, con uno sguardo preoccupato. Un altro paio di mani, piuttosto bizzarro e impreciso, sfiora la donna dall’altro lato.

Queste donne non esistono. Sono il frutto delle sperimentazioni dell’artista tedesco Boris Eldagsen e della sua collaborazione con DALL-E 2, il modello generativo della compagnia americana OpenAI. L’immagine che ho descritto, intitolata «The Electrician», si è aggiudicata il primo premio al Sony World Photography Awards 2023. La decisione ha causato inevitabilmente un certo scandalo portando anche all’interno del mondo fotografico una serie di dibattiti legati all’avvento dei modelli «Text-To-Image» (TTI).

C’è, anzitutto, un problema di definizione: «The Electrician» è una fotografia? Lo stesso Boris Eldagsen ha dichiarato di apprezzare il neologismo «promptografia» (dall’inglese «promptography») [1], che evidenzia il ruolo fondamentale del prompt, l’istruzione testuale che diamo alla macchina e che scatena il processo di generazione. C’è chi è arrivato a definire un nuovo movimento artistico con al centro l’atto del prompt, chiamato appunto «promptismo».

Il promptè l’espressione dell’autorialità umana, è l’elemento personale che si relaziona con la macchina. Se immaginiamo il nostro modello generativo come una barca lanciata in un oceano di dati, allora la manipolazione dell’input è il modo in cui possiamo guidare questa barca e portarla a seguire certe correnti invece che altre. Il promptè anche il modo di relazione che abbiamo con l’interfaccia, l’unico strumento per raggiungere il risultato desiderato.

A dire il vero, l’idea stessa di «risultato desiderato» è piuttosto traballante in questo ambito: ci si può approcciare al terminale con un’idea precisa di ciò che si vuole ottenere per poi venire progressivamente deviati dai risultati proposti dalla macchina nel corso delle iterazioni. Non dobbiamo dimenticare che questi algoritmi si basano su una fondamentale componente stocastica che rende poco lineare il processo creativo. Nelle parole di Mat Dryhurst, artista e ricercatore: «È come fare una jam, dare e ricevere feedback mentre si affina un’idea con un collaboratore inumano, senza soluzione di continuità. Si percepisce intuitivamente come uno strumento per fare arte» [2].

I modelli «Text-To-Image» sono l’ultimo, importante passo di un progressivo processo di automazione delle funzioni della fotografia e, più in generale, della produzione di immagini. Contestualizzando questo percorso, Elke Reinhuber (media artist, educatrice e ricercatrice) afferma che ci troviamo in una nuova era, quella della «sintografia»: «La metodologia della produzione sintetica si riferisce all’intelligenza artificiale, ma comprende anche le immagini renderizzate da software 3D» [3].

Potremmo dire che le sintografie nascano dall’’ibridazione tra tecniche di fotografia tradizionale e metodi automatizzati basati sul «machine learning». Reinhuber include nelle produzioni sintografiche tutta una serie di procedure in cui la macchina classifica, corregge o migliora il lavoro umano, come ad esempio, riconoscimento e classificazione delle immagini, messa a fuoco retrospettiva, inquadratura retrospettiva/ritaglio consapevole dei contenuti, profondità di campo retrospettiva, adattamento di diverse caratteristiche dell’obiettivo.

L’utilizzo di queste tecniche viene quasi dato per scontato e difficilmente qualcuno le considera esterne al campo della fotografia. Solo retrospettivamente, con l’avvento dei modelli generativi, e della loro assoluta «sinteticità», possiamo parlare di sintografia come di un nuovo paradigma di produzione di immagini.

A livello filosofico, come notato da Francesco D’Isa [4], le sintografie non possiedono più quel valore di testimonianza che era invece proprio delle fotografie. Lo dimostra una serie di immagini che avrete visto in giro per il web: Donald Trump che si dimena tra le braccia degli agenti federali, Papa Francesco che indossa un giubbotto bianco simil-Balenciaga, Emmanuel Macron che scappa inseguito dalla folla, e altre ancora. Anche queste sintografie, così come quella premiata di Boris Eldagsen, rappresentano eventi irreali nonostante il loro sorprendente fotorealismo. Come spiega D’Isa, «Questi strumenti ci pongono davanti all’ultimo stadio della post-verità, ovvero l’impossibilità della fede, una sorta di scetticismo all’ennesima potenza: se non sono più in grado di capire dov’è l’inganno, non posso credere in nulla di cui non sono testimone».

Quanto saranno estese le conseguenze di un tale terremoto epistemico, è ancora troppo presto per dirlo. Eppure, sembra chiaro sin da questo biennio 2022-23 che non si possa far tornare il genio nella lampada.

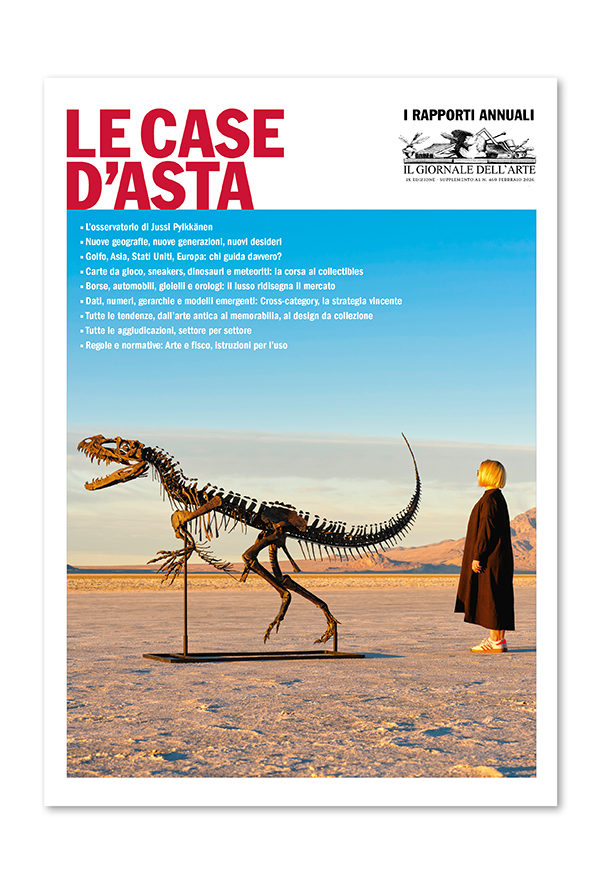

Microsoft Campus in Quincy. Fonte: Microsoft

Nessuna intelligenza artificiale su un pianeta morto

Per arrivare al cuore di questo articolo, che è il più ingombrante non-detto sul tema dell’IA, è tempo di rivolgerci ad un’altra immagine, una vera fotografia questa volta. Il panorama che vedete qui sopra è quello dello stato di Washington, nel nord ovest degli Stati Uniti. Più precisamente, la foto ritrae le campagne vicino alla cittadina di Quincy, 6.750 abitanti secondo Wikipedia, a due ore e mezza di auto da Seattle. A spezzare la placidità del paesaggio, ci sono una serie di hangar argentati che contengono i data center di Microsoft. I data center sono le strutture fisiche in cui vengono custodite le varie componenti dell’infrastruttura IT di un’organizzazione, come router e sistemi di memoria.

Nell’ultimo decennio, questi centri hanno assunto un grande valore strategico ed economico, soprattutto a partire dalla diffusione del «cloud computing». Quando salviamo le nostre fotografie sul «cloud», siamo portati a pensare a una sorta di empireo immateriale in cui miracolosamente gli oggetti non hanno un peso e non occupano spazio. Il «cloud» in realtà assomiglia molto all’interno di uno dei data center di qui sopra: immensi corridoi raffreddati, quasi del tutto privi di popolazione umana, in cui il silenzio è rotto solo dal ronzio delle macchine. Quando usiamo servizi come Amazon Web Services o Azure di Microsoft, non stiamo pagando l’accesso a una qualche misteriosa «nuvola», stiamo semplicemente usando il computer (più potente) di qualcun’altro.

Il banale inganno del «cloud»è stato al centro dell’esibizione «Songs of the Sky: Photography & the Cloud» presso il C/O di Berlino. Evan Roth, artista di origine statunitense, ha proposto un’installazione dedicata al progetto «Landscapes». Iniziato nel 2014, «Landscapes»ha portato Roth a viaggiare per il mondo nel tentativo di catturare, attraverso il medium fotografico, la materialità nascosta della rete, di cui l’idea di «cloud» fornisce un esempio perfetto.

Roth ha intrapreso un viaggio per esplorare e documentare i punti di intersezione tra il mondo digitale e fisico, osservando in particolare i luoghi dove i cavi in fibra ottica di Internet emergono in superficie. Questo studio approfondito ha prodotto una serie di «video posizionati in rete»: opere multimediali conservate su server che risiedono nello stesso luogo geografico in cui sono state create, e i cui URL sono formati dalle coordinate GPS del luogo di ripresa. Roth ha utilizzato una videocamera personalizzata, progettata per catturare la stessa frequenza infrarossa che percorre i cavi in fibra ottica. La manifestazione concreta di Internet è stata utilizzata come punto di partenza per esplorare la natura e comprendere meglio come le crescenti richieste della tecnologia influenzano la nostra cultura. Tramite la lente della materialità infatti siamo in grado di capire fino a che punto la cosiddetta rivoluzione digitale stia plasmando il mondo a sua immagine, modificando anche paesaggi remoti e all’apparenza poco connessi.

Torniamo ora al data center di Quincy. L’infrastruttura di Microsoft sta venendo espansa negli ultimi mesi. Secondo Tim Zaman, responsabile dell’infrastruttura AI di Tesla e di Twitter, dietro a questa decisione ci sarebbe proprio la necessità di accomodare la sempre maggiore potenza di calcolo richiesta da ChatGPT, il chatbot di OpenAI, e in, misura minore, di DALL-E 2.

«The Electrician» di Boris Eldagsen

Cosa c'entra Open AI?

Cosa c’entra OpenAI con Microsoft? La (ex)noprofit OpenAI è legata al colosso di Bill Gates da una serie di investimenti e accordi che risalgono al 2019. Nel gennaio 2023, le due hanno rinnovato la loro partnership [5], in particolare sui seguenti punti:

● «Supercomputing su scala - Microsoft aumenterà i propri investimenti nello sviluppo e nella distribuzione di sistemi di supercomputing specializzati per accelerare l’innovativa ricerca indipendente sull’IA di OpenAI. Continueremo inoltre a sviluppare l’infrastruttura leader di Azure per l’IA per aiutare i clienti a costruire e distribuire le loro applicazioni di IA su scala globale. [...]»

● «Fornitore esclusivo di cloud - In qualità di fornitore esclusivo di cloud di OpenAI, Azure alimenterà tutti i carichi di lavoro di OpenAI in ambito di ricerca, prodotti e servizi API.»

Microsoft fornisce investimenti e infrastrutture a OpenAI, come i fondamentali «supercomputer su larga scala», per accelerare lo sviluppo dei sistemi automatici di OpenAI, e intanto diventa l’unico fornitoredei servizi cloud per i prodotti e i servizi di OpenAI. Questo significa che il funzionamento di ChatGPT o DALL-E 2 dipende esclusivamente dall’infrastruttura IT di Microsoft.

Fermiamoci un secondo. Abbiamo chiuso il cerchio. La prima immagine che ho descritto, «The Electrician», generata con DALL-E 2 è ora legata alla seconda, la foto del data center di Quincy. In un certo senso, la seconda immagine è la causa efficiente, il motore, che ha prodotto la sintografia premiata dal Sony World Photography Awards. È questo il grande rimosso nel dibattito contemporaneo sull’IA e le industrie creative: la materialità di queste tecnologie, il loro consumo energetico e l’impatto che hanno sul nostro pianeta. Al netto delle questioni autoriali, legali e concettuali, questi sistemi funzionano grazie a una infrastruttura vasta, distribuita in vari luoghi e dipendente dallo sfruttamento delle risorse della Terra.

L ‘AI Now Institute [6] (un think tank che studia gli impatti di queste tecnologie) ha evidenziato la portata del problema nel suo report sul panorama dell’IA nel 2023, dedicando una piccola sezione all’impatto climatico di questi sistemi. Per capire la questione, è necessario comprendere che le attuali tecniche di machine learning,alla base degli avanzamenti degli ultimi anni in campi come la generazione di testi o di immagini, sono molto costose dal punto di vista computazionale e, di conseguenza, energetico. Lo sviluppo dell’IA si basa, infatti, principalmente su avanzamenti di tipo quantitativo: i modelli di apprendimento, come GPT-3, diventano sempre più «large», aumentando sia la quantità di dati su cui vengono allenati sia i parametri per categorizzare questi dati.

Dal momento che OpenAI, con un approccio decisamente poco «open», non rilascia pubblicamente questi dati, è necessario affidarsi ai calcoli di ricercatrici come Timnit Gebru per capire la magnitudine di questi modelli. La Gebru ha stimato che GPT-3 usi 175 miliardi di parametri e venga allenato su un database di 45 tera-byte. Sono quantità astronomiche, che necessitano di una grande potenza di calcolo con enormi costi energetici, infrastrutture e hardware specializzato. I data center come quello di Quincy non solo producono emissioni di CO2 ma consumano grandi quantità di acqua, come descrive il paper «Water Justice and Technology: The COVID-19 Crisis, Computational Resource Control, and Water Relief Policy», sempre a cura dell’AI Now Institute.

L’acqua usata per raffreddare le macchine spesso proviene dalle forniture idriche pubbliche, già sottoposte a stress a causa di decenni di crescita e di investimenti insufficienti nelle stesse (soprattutto nel Midwest e nel Sud degli USA). I data center finiscono così per inasprire situazioni di scarsità idrica scatenando le legittime proteste delle comunità locali: è il caso dei Paesi Bassi, dove, nella primavera del ‘21, il governo ha dovuto dare ragione ai cittadini, vietando temporaneamente la costruzione di nuovi data center [7].

Questione di calcoli

A livello software, il boom dell’IA porta nuove problematiche. I processori dei computer tradizionali (le CPU) sono troppo lente per una tale quantità di calcoli; al loro posto vengono usati i processori grafici (le GPU), inizialmente erano destinati ai giochi 3D, ma ora diventati lo standard per le applicazioni di intelligenza artificiale perché possono eseguire molti calcoli semplici contemporaneamente. Il boom del mercato delle GPU, oltre a portare a una scarsità strutturale di queste macchine sul mercato (e alla ricchezza di chi le produce), ha un costo crescente in termini di risorse. Le componenti di una GPU richiedono l’estrazione di terre rare e di altri elementi come piombo, cromo, cadmio e mercurio.

L’acquisizione di questi metalli è dannosa per l’ambiente e la produzione di componenti chimici è tossica, oltre ad avvenire in condizioni di lavoro estreme e di grande sfruttamento. La domanda impazzita per queste componenti esacerba queste problematiche e l’atteggiamento estrattivo che ne guida la produzione. Sam Altman, CEO di OpenAI, ha scherzato su Twitter annunciando che la sua compagnia cerca ingegneri che si divertono a vedere «le GPU sciogliersi» sotto il fuoco dei loro prodotti.

La battuta lapalissiana di Altman rivela la fredda consapevolezza dell’industria dell’IA: si privilegia la funzionalità dei modelli sopra la loro efficienza e si è disposti a spendere un numero quasi infinito di denaro e risorse pur di raggiungere i risultati previsti. Questa corsa agli armamenti computazionali, con il relativo aumento dei costi, porta ad un aumento delle disuguaglianze nell’industria e impedisce agli attori più piccoli di fare ricerca d’avanguardia, prospettando un prossimo futuro in cui queste tecnologie saranno nelle mani di un paio di grandi compagnie e alimentando così l’oligopolio delle Big Tech.

Inoltre, va specificato come questi costi (ambientali, energetici e monetari) non siano relativi alla sola fase di addestramento dei modelli ma anche in quella dell’«inferenza», vale a dire dell’esecuzione di una richiesta che richiede un «ragionamento» da parte del modello e un conseguente «attraversamento» del «data space»in cui si muove: in altre parole, anche quando il software è stato costruito o addestrato, l’esecuzione dei modelli linguistici di grandi dimensioni richiede un’enorme quantità di potenza di calcolo, perché essi eseguono miliardi di calcoli ogni volta che rispondono a una richiesta. Si tratta perciò di un enorme costo strutturale che caratterizza l’avvento di questi sistemi e il modo in cui si evolveranno nel futuro.

Nel 2019 un gruppo di studiosi pubblicò un paper programmaticamente intitolato «Green AI» [8] evidenziando l’incompatibilità tra la crisi climatica e il modello di sviluppo attuale del machine learning. Nel paper, quest’ultimo veniva chiamato «Red AI» e, nonostante i risultati ottenuti, veniva descritto come sempre meno sostenibile e inclusivo (per i motivi sopra indicati). Gli autori propongono di valutare maggiormente l’efficienza computazionale dei modelli così da incentivare la ricerca di modelli più sostenibili e che necessitano di meno risorse.

«Il termine Green AI si riferisce alla ricerca sull’intelligenza artificiale che produce risultati innovativi senza aumentare il costo computazionale e, idealmente, riducendolo. Mentre la Red AI ha portato a un rapido aumento dei costi computazionali (e quindi delle emissioni di carbonio), la Green AI ha sortito l’effetto opposto. Se le misure di efficienza saranno ampiamente accettate come importanti parametri di valutazione per la ricerca insieme all’accuratezza, allora i ricercatori avranno la possibilità di concentrarsi sull’efficienza dei loro modelli con un impatto positivo sia sull’ambiente che sull’inclusività.»

Man mano che tecnologie come i modelli «Text-to-Image» diventano più popolari e adottate, nella fotografia così come in altri ambiti, diventerà sempre più importante tenere presente la materialità dell’assemblaggio che chiamiamo sommariamente «Intelligenza Artificiale», cercando altri modelli rispetto a quello dominante. Sarà necessario ricordare che le radici di questa Idra tecnologica affondano nei minerali e nelle rocce e nelle acque dei fiumi. Nell’epoca dell’Antropocene, non possiamo permetterci di sacrificare ulteriormente la Terra in nome di un fantomatico progresso. «Non esiste Intelligenza Artificiale su un pianeta morto.»

Alessandro Y. Longo è uno scrittore e ricercatore che vive a Berlino. Cura REINCANTAMENTO, una meditazione open-source e work-in-progress su magia e tecnologia. Lavora anche sui limiti della computazione e sulle resistenze sonore. Reincantamento.xyz è l’indirizzo del suo «giardino digitale».

[1] Katherine Matthews,The AI Revolution: An Interview with Boris Eldagsen on Winning (and Refusing) the Sony World Photography Award, 2023

[2] Herndon Holly & Dryhurst Matt, Infinite Images and the latent camera, 2022

[3] Elke Reinhuber, Synthography – An Invitation to Reconsider the Rapidly Changing Toolkit of Digital Image Creation as a New Genre Beyond Photography. In: Wölfel, M., Bernhardt, J., Thiel, S. (eds) ArtsIT, Interactivity and Game Creation, ArtsIT 2021, 2022

[4] Francesco D’Isa,La verità nell’era della riproducibilità artificiale, 8 Production, 2023

5] Dal blog di Microsoft,Microsoft and OpenAI extend partnership, 2023

[6] Amba Kak e Sarah Myers West,AI Now 2023 Landscape: Confronting Tech Power, AI Now Institute, April 11, 2023

[7] Dan Swinhoe, Update: Hollands Kroon facing drinking water shortage if new data centers are built, Data Center Dynamics, 2021

[8] Roy Schwartz, Jesse Dodge, Noah A. Smith, Oren Etzioni, Green AI, 2020